検索における 25 の進化 : 役立つ画像から AI まで

Google 検索 を 25 年前にスタートさせたとき、先行する検索エンジンはすでに存在していましたが、Google 検索を実際に利用したみなさんから、想像以上に早く探している正しい情報にたどり着けると、すぐに広く知っていただけることとなりました。

Google は、長年の技術革新と共に日々 Google 検索を改善してきました。これまでにない新しい検索方法の開発、数百万の企業と顧客をつなげる検索リストや広告による支援 (2001 年に AdWords に初めて広告を出稿したのは、ローカルビジネスでした ) から、 Doodle やイースター エッグといった楽しみなど、その道程は起伏に満ちたものでした。

Google の 25 周年という節目に、Google 検索をより便利で役立つ存在にし、現在の Google 検索に大きな役割を果たしている瞬間をいくつか振り返ってみましょう。

2001:画像検索

米歌手のジェニファー ロペスが 2000 年のグラミー賞に出席したとき、 彼女の大胆なヴェルサーチのドレス は瞬く間にファッション界の伝説となり、当時の Google 検索で最も人気のクエリになりました。しかし、当時の検索結果はサイトへのリンクの一覧のみ。ユーザーが求める写真を見つけるのは、簡単ではありませんでした。これが Google 画像検索 を開発するきっかけになりました。

2001年:「もしかして」

スペルの修正を提案する「もしかして」は、機械学習の最初の応用例のひとつでした。それまでは、誤ったつづりで検索すると、同じつづりの間違いをしている別のページが表示され、そういったページは検索結果として最適なものでないことがほとんどでした。Google は、それから何年もかけて、つづりの間違いをしても必要な情報に確実にたどり着けるよう、 AI を活用した新しい技術を開発 してきました。

2002:Google ニュース

2001 年 9 月 11 日に悲惨な出来事が発生しているとき、人々はタイムリーなニュースや情報を Google 検索で必死に探しました。リアルタイムのニュースを知りたいというニーズを満たすため、同じトピックのニュースについて、さまざまな出典からの記事を整理して表示した Google ニュース を 2002 年に開始しました。

2003:イースターエッグ

Google の社員は、検索に隠された イースターエッグ (隠しコマンド)を数多く開発してきました。2003 年に登場した最初のイースターエッグのひとつは、「 人生、宇宙、すべての答え 」でした。以来「 斜め 」、「 一回転 」など、ポップカルチャーの重要な瞬間を反映したものなど、多くの楽しい隠しコマンドが誕生しました。

初期のイースターエッグは今でも検索で利用できます。

2004:オートコンプリート

考えるのと同じ速さで文字を入力できたらいいと思いませんか?そう思ったら、 オートコンプリート の出番です。「Google サジェスト」として提供を開始したこの機能は、検索窓へ文字を入力し始めると同時に、クエリを予測して言葉の候補を表示します。現在、オートコンプリートによって入力操作が平均 25% 削減されており、1 日に推定 200 年以上の時間が節約されています。

2004:地域の情報

かつて、人々はお店や会社の情報を探すのに電話帳を使ってきました。それが、ウェブの発展によって、地元の情報について、たとえば「渋谷区、ピザ」や「恵比寿の美容室」といった検索ができるようになりました。2004 年、Google ローカル検索により、地図、ルート、レビューなどの関連情報も確認できるようになりました。2011 年には、モバイルで 1 タップで電話ができる Click-to-Call を追加し、外出先でもお店や会社に簡単に連絡できるようになりました。ローカル検索結果は、電話、ルート案内、注文、予約など、毎月平均 65 億件以上の機会を創出しています。

2006:Google 翻訳

オンラインでの言語の壁を打ち破るために、Google の研究者たちは 2002 年に機械翻訳技術の開発を開始しました。その 4 年後、日本語と英語間のテキスト翻訳機能を備えた Google 翻訳 をリリースしました。現在、Google 翻訳は 100 を超える言語をサポートしており、昨年には 24 の言語や方言を追加しました 。

2006:Google トレンド

Google トレンド は、集計データを使用して検索のトレンドを理解するために開発されました。そして毎年年末に「 Year in Search : 検索で振り返る 1 年」も発表しています。現在、Google トレンドは、無料で提供されている同種のデータセットとしては世界最大級であり、ジャーナリスト、研究者、学者、ブランドにとって、時間軸で検索の変化を知る方法として活用されています。

2007:ユニバーサル検索

有用な検索結果には、リンク、画像、動画、地元の検索結果など、関連する情報形式を問わずに含まれるべきです。そこで Google は、すべてのコンテンツ タイプをまとめて検索でき、それを明確で直感的な方法で表示できるようにシステムを再設計しました。その結果生まれた ユニバーサル検索 は、当時の Google 検索において最も根本的な変更でした。

2008:Google モバイル アプリ

Apple の App Store の登場を受けて、iPhone 向けに初の Google モバイル アプリ をリリースしました。 オートコンプリートや「現在地」などの機能によって入力操作が少なくなり、検索がより簡単になりました。小さな画面では特に便利になりました。現在では、Google アプリ (Android, iOS ) が出来ることは多様になり、たとえば Google レンズ を使って数学の解き方を学んだり、タップするだけで画像のテキスト翻訳にアクセスしたりできます。

2008:音声検索

2008 年に Google モバイル アプリに 音声検索 の機能を導入し、2011 年にはパソコン向けにも拡張しました。ユーザーはマイクのボタンをタップすることで音声による検索を開始できます。現在、音声による検索はインドで特に人気があり、毎日音声クエリを実行するインド人の割合は世界平均のほぼ 2 倍になります。

2009:緊急ホットライン

娘が危険と思われるものを飲み込んだときに中毒関連情報がなかなか見つからなかった、と言う母親からの投書を受けて、関連する検索結果ページの上部に毒物管理ホットラインを表示することにしました。 このリリース以降、自殺予防など、一刻を争う場合の 緊急ホットライン を上部に表示するようにしています。

2011:画像で検索

場合によっては、探しているものを 言葉で説明するのが難しい 場合があります。そこで、「画像で検索」を開始しました。写真をアップロードしたり、画像の URL を入力したりすることで、Google 検索したり、他の画像を確認したりできるようになりました。このアップデートにより、後の Google レンズへの道が開かれました。

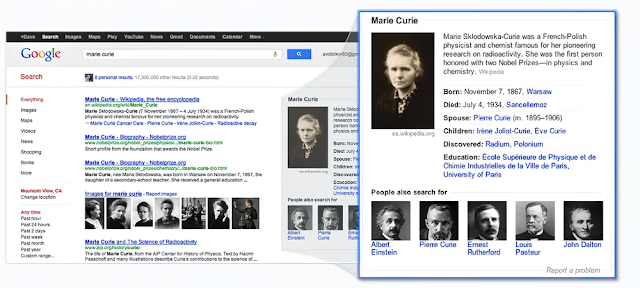

2012:ナレッジグラフ

ナレッジグラフ は、世界中の人、場所、物事と、それらが互いにどう関連しているかについての事実を集めた巨大なバーチャル百科事典のようなものです。人々がすばやく答えを見つけることができるよう、Google はこの機能を導入しました。ナレッジグラフを利用した最初の機能である ナレッジパネル は、有名人、都市、スポーツチームなどに関する情報の概要を提供しています。

2015:混雑する時間帯

ユーザーがレストラン、店舗、美術館などの場所を検索する時に、1 日の中で最も混雑する時間帯を確認できるよう、Google 検索と Google マップに 混雑する時間帯機能 を追加しました。

2016:Discover

パーソナライズされたフィード (現在の Discover) の提供を開始してから、検索する以外にも Google アプリ内で自分の興味に合ったコンテンツを探索できるようにしました。

2017:Google レンズ

Google レンズ は、写真の中の被写体を他の画像と比較し、元の画像との類似性や関連性に基づいて、比較対象の画像をランク付けすることで、目の前にあるものを検索クエリに変換しています。現在では、Google アプリ内に表示された画像も Google レンズで検索することができ、Google レンズを使った画像検索の数は、毎月 120 億件以上に達しています。

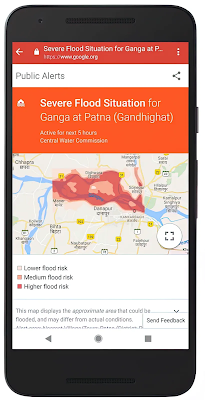

2018:洪水予測

迫りくる洪水に人々が適切に備えられるようにするため、Google は AI を活用して洪水発生の時期と場所をより正確に 予想するモデル を作成しました。Google はこれらの取り組みをインドで開始し、現在では 80 か国に 洪水警報の対象地域を拡大しています。( 日本未対応 )

2019:BERT

Google 検索が役立つには、言語を理解する能力が重要な要素です。2018 年、言語理解モデルをトレーニングするために、ニューラル ネットワーク ベースの手法である BERT (Bidirectional Encoder Representations from Transformers) を導入し、オープンソース化しました。BERT は言語をより深く理解することで、 検索をより便利なものにします 。つまり、単語の文脈を考慮します。厳格なテストの後、2019 年にGoogle は BERT を 70 を超える言語に適用しました。

2020:Shopping Graph

すべての小売店やブランドが Google ショッピング上で自社の製品を 無料 で表示できるようになり、オンライン ショッピングが非常に簡単かつ包括的になりました。また、製品のリアルタイム更新、販売者、ブランド、レビュー、在庫を AI を活用してデータセット化する Shopping Graph も導入しました。現在、Shopping Graph は約 350 億件の製品リストによって構成されています。

2020:鼻歌検索

Google アプリで 鼻歌検索の機能を発表しました。これで、メロディーが頭から離れないのに、曲名が思い出せなくて、もどかしく感じることがなくなります。機械学習機能により、ハミングしたり、口笛を吹いたり、メロディーを歌ったりするだけで、該当する可能性のある曲が見つかるようになりました。さらに、その曲やアーティストについての情報を調べることができます。

2021年:この結果について

検索結果のどれが役立ちそうか、ユーザーがより多くの情報に基づいて判断できるよう、多くの結果の横に「 この結果について ( ベータ版 ) 」を追加しました。この機能は、情報リテラシーの専門家によるベストプラクティスに基づいて、その検索結果が表示された理由を説明し、情報源と内容に関するより詳細なコンテキストを提供するものです。現在、この結果については、検索が利用できるすべての言語で表示されます。

2022:マルチ検索

必要とするものを言い表すのが難しくても、求めている情報を見つけやすくするために、テキストと画像を同時に検索するまったく新しい検索方法、 マルチ検索 を開発しました。これにより、ダイニングテーブルの写真を撮り、「コーヒーテーブル」と文字情報を加えることで、同じデザインのコーヒーテーブルを探すこともできます。現在 Google レンズ が利用可能なすべての言語および国で、スマートフォンでお使いいただけます。

2023:Search Labs と生成 AI による検索体験 (SGE)

Google 検索では、毎年数十万回にも及ぶテストを行い、Google の利便性を高める方法を模索しています。 Search Labs では、希望するユーザーのみなさんが初期段階の試験的な機能を試し、担当しているチームにフィードバックを直接伝えることができます。 その一つである 生成 AI による検索体験 (SGE) では、生成 AI の機能を Google 検索に直接取り入れています。AI によって生成された概要、さらに調べるためのヒント、フォローアップを求める自然な方法によって、トピックの要点を知ることができます。米国でのリリース以来、日本やインドでも試験運用を開始し、今後も機能を加ていく予定です。

20 年以上にわたって検索エンジンの世界に関わってきた者として、Google がどこからスタートし、何を達成してきたかを振り返るのは、非常に感慨深いものでした。より詳しい情報は、 Google の歴史 のサイトをご覧ください。

![[JAPAN] SGE Press Briefing Deck for i18n 08292023](https://storage.googleapis.com/gweb-uniblog-publish-prod/images/JAPAN_SGE_Press_Briefing_Deck_f.max-960x332.format-webp.webp)